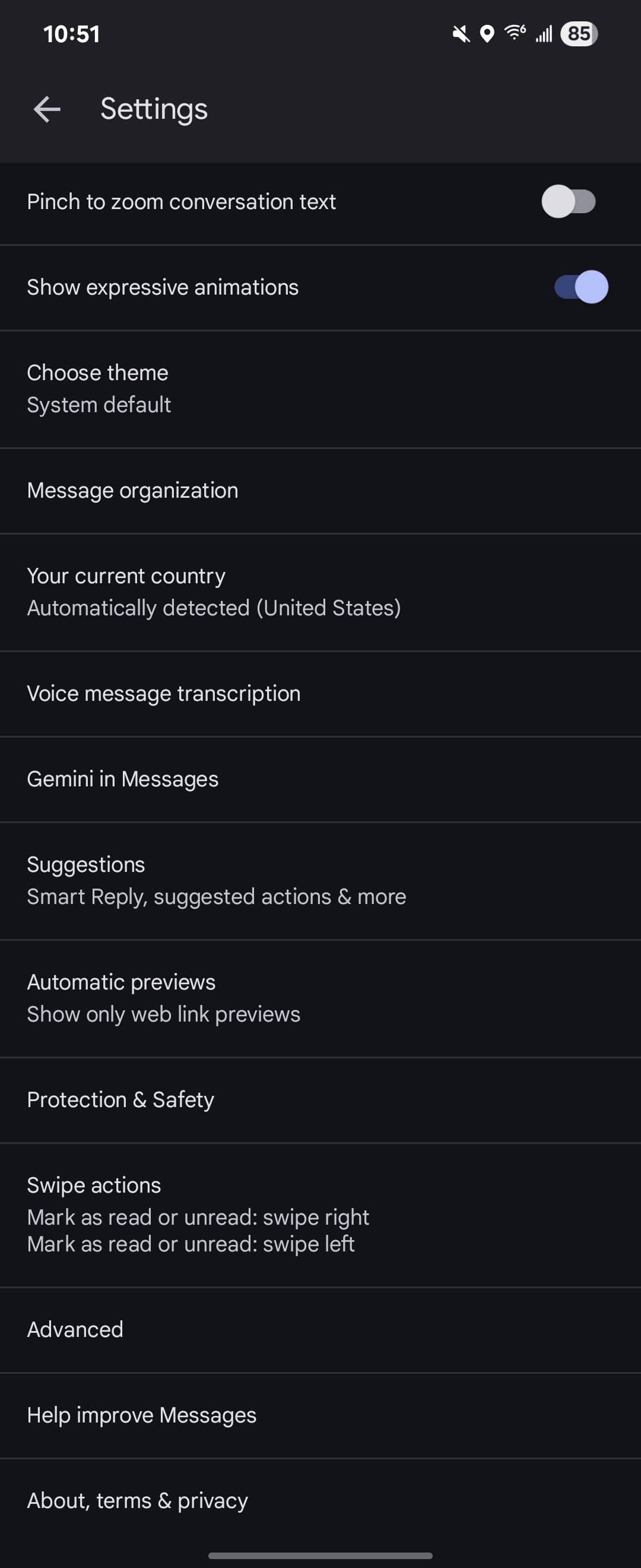

近期,据外媒9To5Google报道,谷歌信息App正针对部分用户测试一项名为“敏感内容警告”的新功能。此功能借助AI技术,能在用户发送或接收消息时自动识别并处理包含敏感内容的图片。

具体而言,当该功能启用后,用户在接收图片消息时,App会即时检测图片内容。一旦识别到图片中包含敏感元素,系统将自动对图片进行模糊处理。用户需通过二次确认,选择“查看原图”或“删除”。用户还拥有一键屏蔽发送者的选项,以增强信息安全性。

在发送或转发图片消息时,如果图片被判定为包含敏感内容,系统会立即弹出风险提醒。用户需手动确认后,方可继续发送。这一机制旨在预防不当内容的传播,保护用户的隐私和安全。

谷歌方面表示,该功能采用Android System SafetyCore的本地AI技术,确保在识别敏感内容时,不会将任何图像数据上传至谷歌服务器,从而保护用户的隐私。

对于未成年人用户,该功能默认开启。若家长通过Family Link应用监管孩子账户,将能够控制此功能的设置。非家长监管的未成年人账户,以及成年人账户,该功能则默认关闭,用户可根据需要手动开启。

目前,该功能仍处于测试阶段,尚未公布正式推送的时间表。据9To5Google报道,他们在多台设备上更新了谷歌信息App,但仅在两台设备上收到了该功能的推送。