摩尔线程今日宣布了一项重大开源举措,正式推出了MT-MegatronLM与MT-TransformerEngine两大AI框架。这一举措标志着摩尔线程在国产全功能GPU上实现了混合并行训练和推理的重大突破。

据摩尔线程官方介绍,MT-MegatronLM是一个专为全功能GPU设计的开源混合并行训练框架。它不仅能够支持dense模型和多模态模型的高效训练,还特别擅长处理MoE(混合专家)模型。而MT-TransformerEngine则专注于Transformer模型的训练与推理优化,通过一系列技术革新,如算子融合和并行加速策略,充分挖掘了摩尔线程全功能GPU的计算潜力。

两大框架的技术亮点在于硬件适配与算法创新的深度融合。其中,混合并行训练技术能够灵活应对不同模型架构的复杂运算场景,而FP8混合训练策略则结合摩尔线程GPU原生支持的FP8混合精度训练,有效提升了训练效率。高性能算子库muDNN与通信库MCCL的深度集成,进一步优化了计算密集型任务和多卡协同的通信开销。

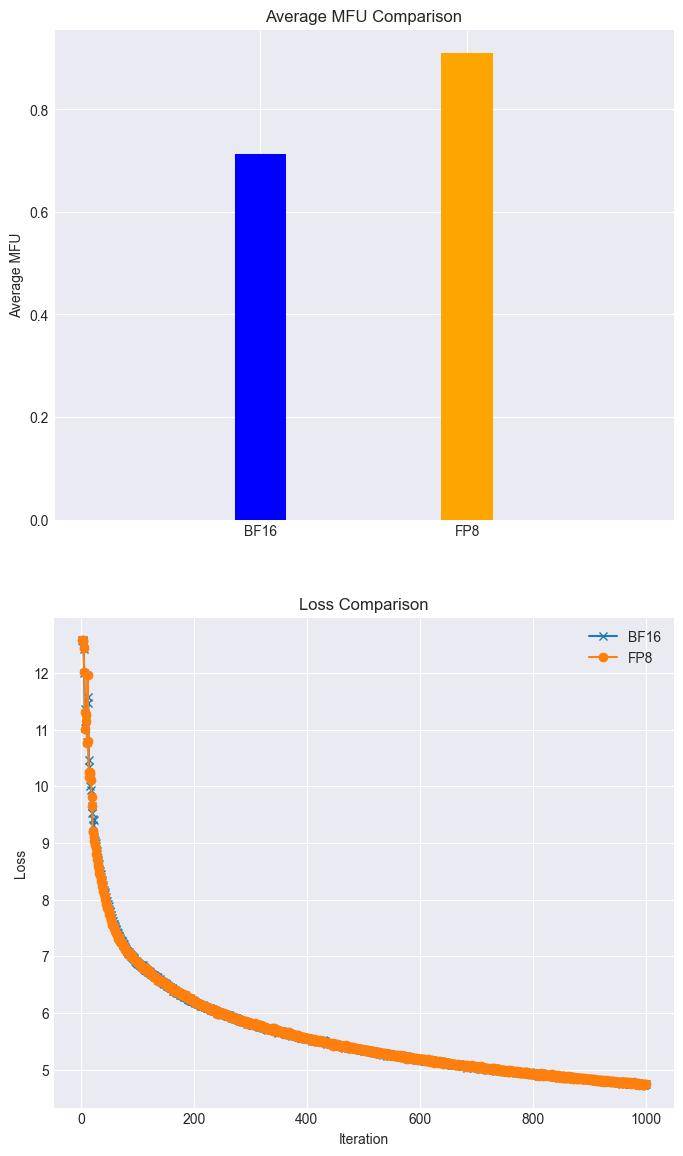

在实际应用方面,摩尔线程展示了令人瞩目的成果。在全功能GPU集群上,Llama3 8B模型的训练任务在FP8混合精度加速技术的加持下,实现了28%的加速,且loss几乎无损。同时,摩尔线程还成功复现了DeepSeek满血版训练流程,展示了其对复杂AI训练任务的高效支持。

两大框架还具备完善的异常处理和兼容性。内置的rewind异常恢复机制能够自动回滚至最近稳定节点继续训练,确保了大规模训练的稳定性。同时,两大框架兼容GPU主流生态,为开发者构建自有的AI技术栈提供了底层支撑。

摩尔线程官方表示,他们将持续优化MT-MegatronLM与MT-TransformerEngine框架,并引入更多先进功能。未来,用户将能够体验到Dual Pipe / ZeroBubble并行策略带来的更高并行训练效率,以及多种FP8优化策略带来的性能和稳定性提升。异步checkpoint策略和优化后的重计算策略也将进一步提高训练过程中的容错能力和效率。

摩尔线程的这一开源举措无疑为AI领域注入了新的活力。通过开放两大核心框架,摩尔线程不仅展示了其在国产GPU技术上的深厚积累,也为广大开发者提供了一个强大的AI开发平台。未来,随着框架的不断优化和功能的持续引入,我们有理由相信,摩尔线程将在AI领域取得更加辉煌的成就。

对于感兴趣的开发者和研究人员,可以通过以下链接获取两大框架的开源代码:

MT-MegatronLM开源地址:https://github.com/MooreThreads/MT-MegatronLM

MT-TransformerEngine开源地址:https://github.com/MooreThreads/MT-TransformerEngine

摩尔线程Simumax开源地址:https://github.com/MooreThreads/SimuMax