英伟达近期在人工智能领域取得了新突破,推出了一款名为Describe Anything 3B(简称DAM-3B)的先进AI模型,专门用于解决图像和视频中特定区域的详细描述难题。

传统的视觉-语言模型在描述整体图像时表现尚可,但一旦涉及到对图像中某个特定区域的细致描述,尤其是视频中的动态场景,其能力就显得捉襟见肘。英伟达此次推出的DAM-3B模型,正是为了解决这一技术瓶颈。

DAM-3B模型允许用户通过点选、边界框、涂鸦或掩码等方式,精准指定想要描述的目标区域,随后模型会生成与上下文高度契合的精确描述文本。英伟达还推出了DAM-3B-Video版本,专门用于处理动态视频内容。

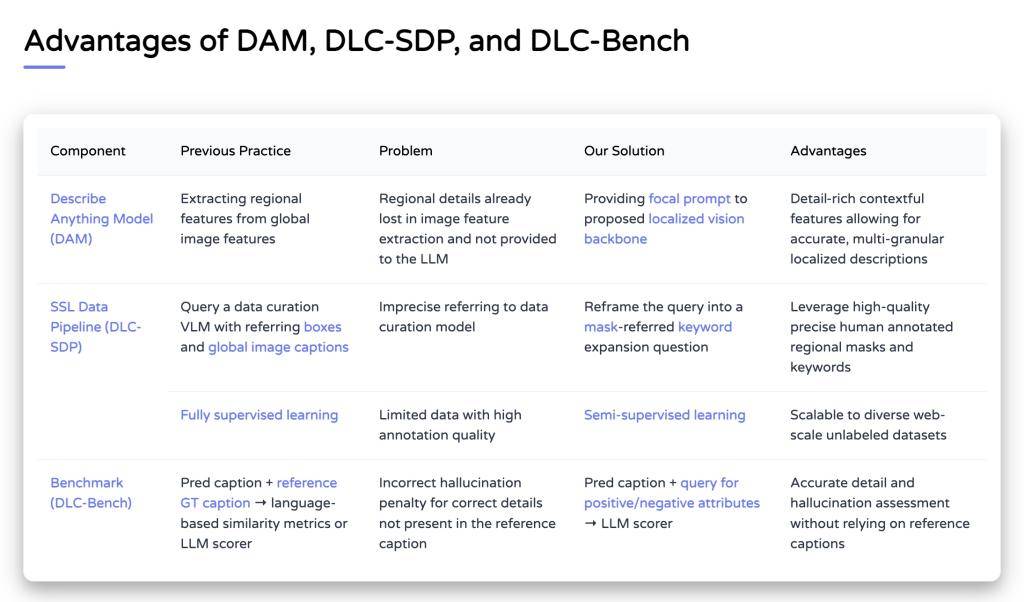

这款模型的核心创新之处在于其独特的“焦点提示”技术和“局部视觉骨干网络”。焦点提示技术结合了全局图像信息与目标区域的高分辨率细节,确保在保留整体背景的同时,不丢失任何关键细节。而局部视觉骨干网络则通过嵌入图像和掩码输入,运用先进的门控交叉注意力机制,将全局特征和局部特征巧妙融合,最终传输至大语言模型生成描述。

为了应对训练数据稀缺的挑战,英伟达开发了一套名为DLC-SDP的半监督数据生成策略。该策略利用分割数据集和未标注的网络图像,成功构建了包含150万局部描述样本的训练语料库。英伟达还通过自训练方法不断优化描述质量,确保输出文本的高精准度。

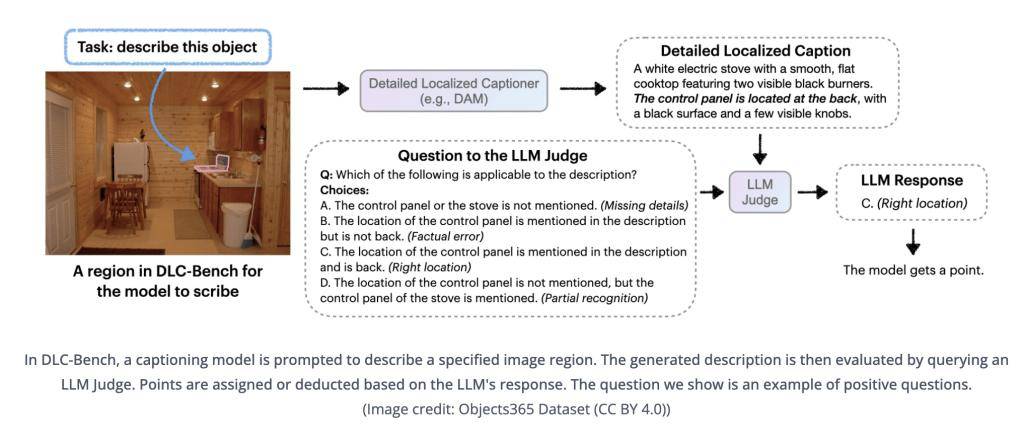

在评估方面,英伟达推出了DLC-Bench评估基准,该基准以属性级正确性来衡量描述质量,而非简单地与参考文本进行对比。这一创新评估方法使得DAM-3B模型在包括LVIS、Flickr30k Entities等在内的七项基准测试中脱颖而出,平均准确率高达67.3%,超越了GPT-4o和VideoRefer等竞争对手。

DAM-3B模型的推出,不仅填补了局部描述领域的技术空白,其上下文感知架构和高质量数据策略还为无障碍工具、机器人技术及视频内容分析等领域带来了全新的可能性。

英伟达此次的技术创新,无疑将推动人工智能技术在图像和视频描述领域的进一步发展,为相关行业带来深远的影响。